Les algorithmes ont envahi nos vies. Malgré tout, ils suscitent parfois des réactions de haine de la part des utilisateurs. Un article publié en Septembre 2022 offre un canevas d’analyse très intéressant pour ceux qui s’intéressent à ce phénomène. Dans cet article j’analyse les 4 raisons qui expliquent les réactions de haine contre les algorithmes et les illustre avec de nombreux exemples.

Si vous n’avez que 30 secondes

- les algorithmes génèrent parfois des réactions violentes de haine de la part des utilisateurs

- 4 raisons expliquent pourquoi la frustration des utilisateurs se transforme en violence verbale :

- manque de connaissance du fonctionnement de l’algorithme et incompréhension des résultats

- erreurs algorithmiques

- intérêts de l’utilisateur opposés à celui de l’algorithme

- manque de contrôle sur l’algorithme

- des solutions existent

- repenser le design des algorithmes pour maximiser la satisfaction utilisateur

- rendre les algorithmes plus transparents et expliquer leur fonctionnement

- donner des possibilité d’ajuster le fonctionnement de l’algorithme

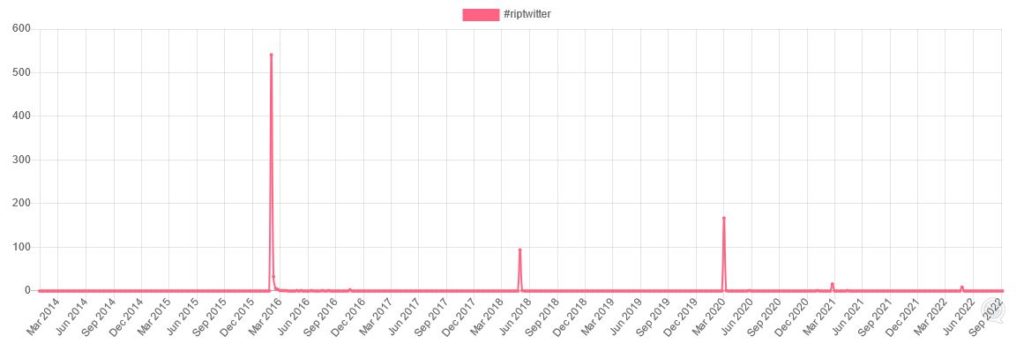

Le phénomène de haine contre les algorithmes se matérialise de différentes manières. Les auteurs de l’étude citent la poussée du hashtag #RIPtwitter lorsque la plateforme a décidé d’utiliser un algorithme de recommandation plutôt qu’un affichage des messages dans l’ordre antéchronologique. A l’époque les utilisateurs avaient réagi violemment comme on peut le voir sur le graphique ci-dessous (source : Trendsmap). On voit d’ailleurs que le hashtag #RIPtwitter réapparaît de temps en temps, lors des pics de haine contre la plateforme.

Le phénomène s’est aussi manifesté sur Instagram avec le hashtag #RIPinstagram en 2017 pour la même raison. Le mécanisme de recommandations algorithmiques semble donc cristalliser des sentiments négatifs.

Pourtant les algorithmes de recommandation sont à la base du succès de nombreuses entreprises (Netflix, Google, Tik Tok) et contribuent aussi à la satisfaction client. Il est dès lors très intéressant de s’interroger sur les raisons qui poussent les utilisateurs à avoir ces réactions de haine.

Explication 1 : Manque de connaissance

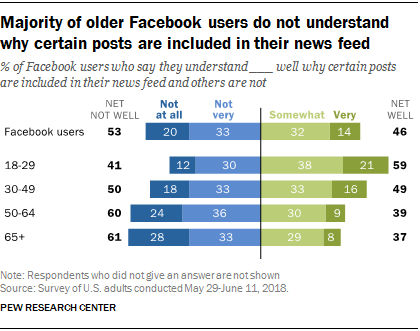

Le manque de compréhension du fonctionnement des algorithmes est un fait. Dans une étude publiée en 2018, le Pew Research Center pointait déjà que 53% des utilisateurs de Facebook ne comprenaient pas le fonctionnement de l’algorithme alimentant leur « feed ». Ce pourcentage atteignait même 60% parmi les 50-64 ans et 61% chez les plus de 65 ans.

La compréhension du fonctionnement d’un algorithme de recommandation reste une matière complexe, réservée à quelques initiés. Pourtant, augmenter le niveau de compréhension des utilisateurs du fonctionnement d’un algorithme présente de vrais avantages. Comme le prouve cette expérience, comprendre le mode de fonctionnement de l’algorithme augmente significativement le niveau de confiance et la satisfaction de l’utilisateur.

Explication 2 : Erreurs et biais algorithmiques

Les algorithmes créent parfois des situations d’une violence extrême contre les utilisateurs. L’erreur algorithmique peut ainsi avoir des conséquences gravissimes, comme dans le cas de cet homme arrêté au Michigan après une identification algorithmique erronée. Citons également l’exemple de candidats locataires refusés après une vérification algorithmique de leur profil ou la ruine de citoyens néerlandais consécutive à la mauvaise utilisation d’un algorithme par le fisc.

Les algorithmes utilisés dans le secteur de l’éducation sont également souvent pointés du doigt. En France, l’algorithme de sélection pour le choix de l’université avait ainsi pu être manipulé, créant des inégalités entre candidats au moment de leur orientation scolaire.

Enfin, certaines communautés peuvent ressentir une discrimination algorithmique lorsqu’elles ont l’impression d’être ciblées injustement pour leur identité. C’est ce qu’il s’est passé sur Tik Tok où des créateurs LGBTQIA+ ont eu l’impression que l’algorithme rendait invisible leurs contenus. Un audit a révélé que ces critiques étaient fondées. A l’inverse, un algorithme peut également surexposer un contenu et le rendre accessible à une trop large audience. Ce faisant les créateurs de contenus peuvent subir des pressions de certains utilisateurs.

On l’aura compris, les risques liés à l’utilisation d’algorithme de recommandation sont nombreux. L’équilibre entre valeur ajoutée pour l’utilisateur et risques est difficile à trouver.

Explication 3 : Les intérêts de l’utilisateur opposés à ceux de l’algorithme

Exemple de Twitter

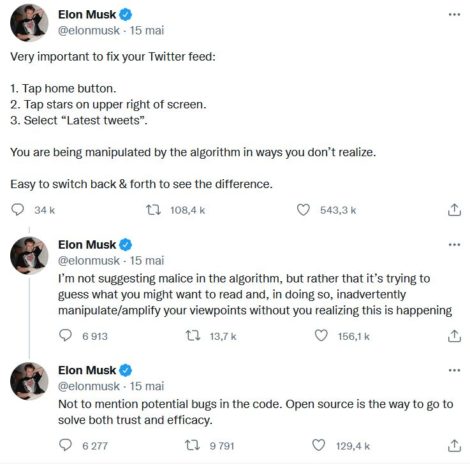

Les utilisateurs d’une plateforme se sentent parfois « manipulés » par l’algorithme. Une série de Tweets d’Elon Musk en donne toute la mesure. Dans ces 3 tweets publiés le 15 Mai 2022, il accuse l’algorithme de « manipuler [les utilisateurs] d’une façon qu'[ils] ne réalisent pas ». Dans son deuxième tweet il évoque la bulle de filtres théorisée par Eli Pariser. L’algorithme de Twitter amplifierait les croyances et polariserait de facto les points de vue.

Dans ce cas, les intérêts de l’algorithme et des utilisateurs ne seraient pas alignés. Cette thèse est contestable car, on l’a déjà vu, les bulles de filtres restent une possibilité théorique.

Exemple de Spotify

Spotify constitue un autre exemple de cette opposition entre intérêts de l’utilisateur et de l’algorithme. Rappelons-nous tout d’abord que Spotify est une plateforme qui propose des contenus audios à des utilisateurs et rémunère les créateurs sur la base du nombre d’écoutes. Un équilibre subtil doit donc être trouvé en satisfaction des utilisateurs et satisfaction des créateurs. Les premiers veulent écouter des contenus qu’ils aiment. Les seconds veulent être écoutés (et donc recommandés) le plus possible.

L’algorithme de Spotify est donc devant un dilemme. Doit-il recommander les contenus qui ont la probabilité maximale de plaire (généralement produits par les grand labels) au détriment de ceux, plus confidentiels, produits par des labels indépendants ? Il n’y a malheureusement pas de solution parfaite à ce problème. Les utilisateurs étant privilégiés (ce sont eux qui payent), les créateurs indépendants peuvent ressentir une frustration vis-à-vis de l’algorithme de Spotify.

Explication 4 : Manque de contrôle

Le problème du contrôle de l’algorithme est une complainte récurrente parmi les utilisateurs, et une source majeure d’insatisfaction. D’ailleurs, certains des exemples que nous avons donnés ci-dessus peuvent y être rattachés.

Tout changement de « recette algorithmique » entraîne immanquablement son lot d’insatisfaits. On l’a vu avec les tweets d’Elon Musk. Plus récemment Instagram a été très critiqué pour sa tendance à ressembler à TikTok. Cela s’est traduit notamment par la recommandation excessive de contenus de type « reels ». Une campagne informelle a été déclenchée par des influenceurs pour demander l’annulation des changements.

Le manque de contrôle se ressent aussi par la capacité de l’algorithme à percer vos secrets sans que vous puissiez y faire opposition. C’est le cas sur TikTok où la précision de l’algorithme donne aux utilisateurs l’impression d’être espionnés.

Comment redonner confiance dans les algorithmes ?

Les algorithmes, par leur nature, restent des objets difficilement compréhensibles par le commun des mortels. Certains, tellement complexes, posent de vrais problèmes de compréhension à leurs concepteurs. Dans ces conditions, comment éviter les réactions épidermiques que certains utilisateurs peuvent avoir.

Les pistes de réflexion sont au nombre de 3 :

1/ Mettre l’humain au centre du design des systèmes de recommandation

Le RGPD a introduit l’idée du « privacy-by-design ». Les concepteurs d’algorithmes devraient faire leurs celui du « satisfaction-by-design ».

La plupart des algorithmes sont en effet conçus avec les intérêts de l’entreprise à l’esprit. Il en découle des comportements qui peuvent être nuisibles pour l’utilisateur (voir ici cette réflexion sur la fin des algorithmes de recommandation).

2/ Rendre les algorithmes plus transparents

L’acceptation des résultats de l’algorithme passe par une meilleure compréhension de comment ils sont produits. Les erreurs algorithmiques seront mieux acceptées si les utilisateurs savent pourquoi elles surviennent. La satisfaction n’en sera que plus haute.

3/ Augmenter le contrôle de l’utilisateur sur les algorithmes

Le dernier axe de réflexion consiste à redonner un peu de contrôle aux utilisateurs pour personnaliser leurs flux. Les initiatives sont de plus en plus nombreuses, comme celle de Linkedin de faire disparaître certains contenus ou auteurs du flux. De toute façon, si vous ne leur donnez pas un peu de contrôle, les utilisateurs chercheront à manipuler l’algorithme. Des études existent par exemple sur le fonctionnement de l’algorithme de Linkedin.

Publié dans Recherche.