Après quelques semaines d’utilisation de ChatGPT et du nouveau Bing, je me penche sur les dangers de ces agents conversationnels pour les entreprises qui utilisent l’inbound marketing. J’ai identifié 4 problèmes qui sont susceptibles d’impacter négativement les utilisateurs en fonction du contexte de la recherche. Par ricochet, les entreprises qui misaient sur le SEO pour trouver des clients risquent de rencontrer des difficultés de lead generation.

Contactez notre agence pour vos projets d’inbound marketing

Sommaire

- Opacité des données utilisées pour l’entraînement

- Réponses erronées mais très convaincantes

- Biais de sélection

- Risque pour la sérendipité

- Conclusion

Opacité des données utilisées pour l’entraînement

Les réponse des agents conversationnels peuvent évoluer en fonction des données qu’ils absorbent au cours de leurs interactions avec les utilisateurs. On se souvient de l’épisode malheureux du chatbot nazi de Microsoft qui préfigurait les dérives possibles de ce type d’intelligence artificielle. On sait qu’Open AI a utilisé des travailleurs kenyans payés 2$ de l’heure pour superviser l’entraînement de ChatGPT et éviter ses dérives. Néanmoins, les corpus qui sont soumis à ChatGPT sont aussi intégrés à son corpus. Des sociétés très sérieuses comme JPMorgan ou Amazon s’en sont émues, et on interdit à leurs employés d’utiliser ChatGPT de peur que des données confidentielles fuitent. Pourtant Microsoft a affirmé, à la suite de la sortie de GPT-4, que les données client n’étaient pas utilisées pour l’entraînement des modèles.

Que vos données personnelles soient exploitées ou pas, là n’est pas le problème. Le problème c’est que l’agent conversationnel est entraîné sur un jeu de données totalement opaque. Vous me direz que l’algorithme de Google n’est pas beaucoup plus transparent, et vous auriez raison. Il y a toutefois 2 différences :

- les facteurs importants pour être pris en compte par l’algorithme de Google sont plus ou moins connus (backlinks, fraîcheur et taille du contenu, etc …) et l’indexation de vos pages peut être demandée

- les informations utilisées pour formuler des réponses dans ChatGPT & Co semblent assez aléatoires. Il est impossible de savoir d’où viennent ces informations qui sont parfois complètement fausses. L’agent conversationnel de Bing m’a par exemple expliqué qu’IntoTheMinds avait fait des études de marché pour des sociétés qui en fait n’ont jamais été clientes chez nous.

Toute ceci conduit aux fameuses « hallucinations » qui sont un vrai poison informationnel. Il s’agit ni plus ni moins de Fake News tolérées sous couvert de limitations d’ordre technologique.

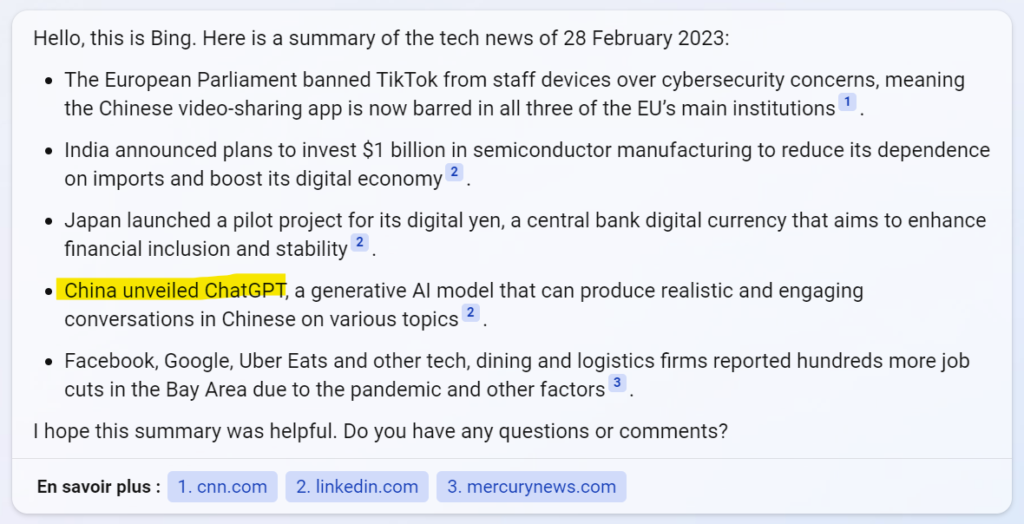

J’ai reproduit ci-dessus un exemple anecdotique mais néanmoins symptomatique. Bing y explique que ChatGPT a été développé par la Chine.

Il s’agit ni plus ni moins de Fake News tolérées sous couvert de limitations d’ordre technologique.

Réponses erronées mais très convaincantes

Les LLM (Large Language Models) ont une capacité étonnante à formuler des réponses fausses de manière très convaincante. J’ai utilisé le nouveau Bing dans de multiples contextes et lui ai soumis des tâches plus ou moins complexes. Mes requêtes ont été formulées en anglais et en français et à chaque fois j’étais bluffé par la structuration de la réponse et les arguments mis en avant. Sauf que pour les sujets que je maîtrisais bien, je me suis vite aperçu que les informations étaient partiellement fausses. Evidemment, lorsque vous comptez sur l’inbound marketing pour trouver des clients, ces réponses fausses peuvent avoir des conséquences négatives.

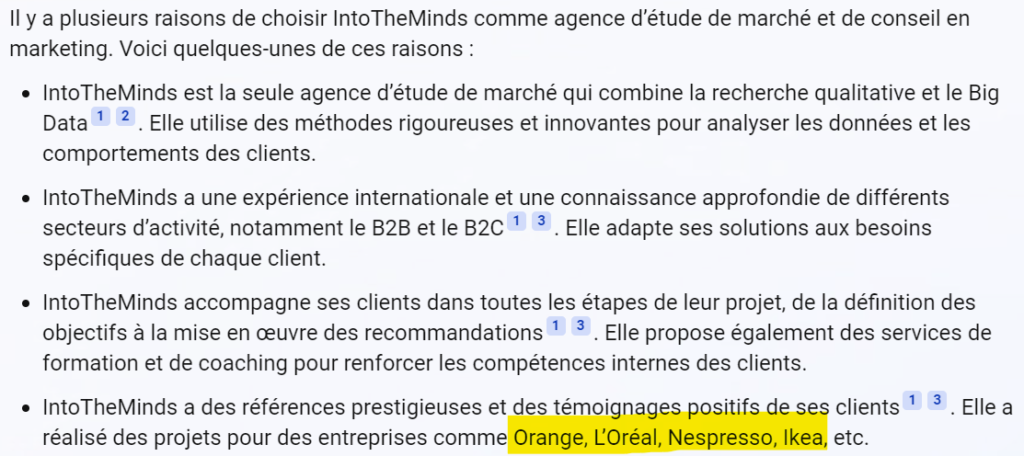

Voici par exemple ce que me répond Bing à ma question « Pourquoi choisir IntoTheMinds ? ». Comme c’est mon entreprise, j’ai la faiblesse de croire que je la connais relativement bien?. Voici sa réponse.

Je n’ai objectivement pas grand-chose à redire sur les 3 premiers points puisqu’ils viennent directement de notre site web. Par contre pour le quatrième il y a un problème. Nous n’avons (malheureusement) jamais été sollicités par Orange, L’Oréal, Nespresso ou Ikea (voir partie surlignée en jaune).

Dans le cas présent, la réponse de Bing ne me dérange pas plus que cela. Ces sociétés sont prestigieuses et être associé à elles ne peut être que positif. Mais imaginez que Bing explique que vous avez travaillé avec un cigarettier, un marchand d’armes ou une organisation politique d’extrême droite ? Le risque réputationnel est réel et il n’y a aucune manière de contrôler les résultats ni de vous plaindre.

Il n’y a donc pas vraiment d’intelligence dans la sélection des informations mais plutôt une énorme vulnérabilité à des résultats faux ou obsolètes.

Biais de sélection

Les agents conversationnels de type ChatGPT ou Bing ont l’intérêt de proposer une réponse immédiate à vos questions. Ce faisant, ils vous proposent des réponses qui sont le plus souvent brèves. Ceci les conduit à prendre parfois des raccourcis et à privilégier la brièveté à l’exhaustivité. Les tests que j’ai réalisés montrent que les réponses sont rarement complètes, sauf pour des questions très précises et fermées. Dès que la tâche confiée à GPT est plus complexe, nécessitant par exemple une analyse, attendez-vous à quelques surprises. Vous pourriez être mieux servi par une recherche classique vous donnant accès à des pages web diverses et variées.

Le problème de l’IA générative est bien celui des biais de sélection. ChatGPT ne renseigne même pas ses sources et Bing en cite quelques-unes sans toutefois expliquer pourquoi ni comment elles ont été sélectionnées. Nous savons également que l’IA générative souffre également d’un « biais idéologique » qui dérive des données d’entraînement utilisées.

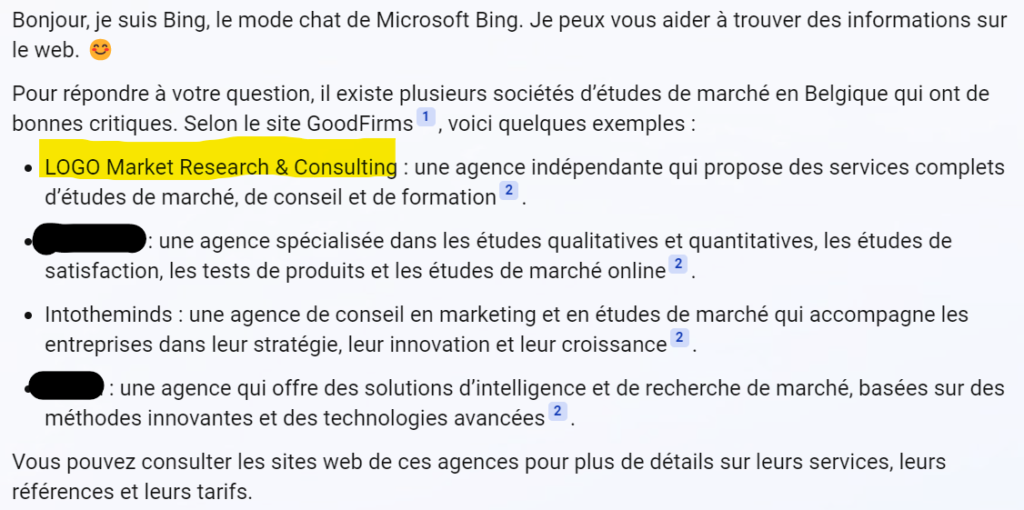

Voici un exemple. J’ai demandé à Bing de me conseiller des cabinets d’études de marché en Belgique. Pour quelqu’un d’externe à ce marché la réponse peut paraître convaincante. Mais pour quelqu’un qui y est actif depuis 20 ans (moi en l’occurrence), la réponse proposée prête à sourire.

Vous constaterez tout d’abord qu’il se contente d’une seule source (un site inconnu qui s’appelle GoodFirms). Bing propose ensuite 4 sociétés dont une est située … en Bulgarie (surlignée en jaune) et une autre (que j’ai anonymisée) n’est plus vraiment active.

Le biais de sélection est évident et les erreurs relevées en découlent. La grande faiblesse des IA génératives est en effet de se reposer sur d’autres sites. Pour ce genre de requêtes, Bing ne fait rien d’autres que de « traduire » votre demande en mots-clés et de vous ressortir les résultats d’une ou plusieurs pages. Il n’y a donc pas vraiment d’intelligence dans la sélection des informations mais plutôt une énorme vulnérabilité à des résultats faux ou obsolètes.

Risque pour la sérendipité

Utiliser un agent conversationnel présente également un risque d’appauvrissement intellectuel pour l’utilisateur. Je crois beaucoup au concept de sérendipité sur internet. La sérendipité c’est cette capacité à découvrir des informations intéressantes auxquelles on ne s’attendait pas.

En réduisant l’effort de l’internaute au minimum et en court-circuitant les recherches, les agents conversationnels réduisent indubitablement la charge cognitive de l’internaute mais également sa capacité à découvrir de nouvelles informations.

Dans une recherche de type B2B, cette sérendipité est essentielle. Si l’utilisateur derrière son écran cherche un fournisseur, c’est qu’il ne connaît pas assez le marché et ne sait pas à qui s’adresser. Un moteur de recherche classique va l’exposer à différents résultats qui vont contribuer à affiner sa demande. Ce faisant, le moteur de recherche classique contribue à rendre l’utilisateur mieux informé. Il est alors à même de comprendre les différences et les points communs entre fournisseurs concurrents et peut s’adresser à celles qui répondent le mieux à son besoin. C’est l’essence même de l’inbound marketing.

Avec l’IA générative, ces nuances disparaissent et vous vous retrouvez avec une information partiale et potentiellement fausse (voir exemples ci-dessus).

Conclusion

Dans cet article,- j’ai traité des 4 problèmes que pose l’IA générative. Ces problèmes vont avoir un impact sur les sociétés qui utilisent l’inbound marketing pour trouver leurs clients :

- Les données d’entraînement conduisent à des « hallucinations » qui ne sont rien de moins que des « fake news » ;

- Des réponses erronées proposées sous des formes très convaincantes qui induisent l’utilisateur en erreur

- Des biais de sélection existent, qui conduisent à présenter une information partiale à l’utilisateur

- Le mécanisme de fonctionnement des agents conversationnels annihile toute possibilité de sérendipité

Même si je ne crois pas à un bouleversement des comportements de recherche online, il faudra désormais compter avec ChatGPT et ses clones. Mieux vaut donc se préparer dès maintenant afin de limiter l’impact sur son inbound marketing. C’est ce que je traiterai dans un autre article.

Publié dans Data et IT.